Pour la chercheuse Anna Jobin, il n’y a rien de surprenant au fait que les intelligences artificielles soient imprégnées de préconceptions. (Illustration : Adobe Stock)

Quelques requêtes suffisent à constater que les intelligences artificielles génératives n’ont rien de neutre. Comment ces préjugés se frayent-ils un chemin jusque dans ces outils ? Rencontre avec la chercheuse fribourgeoise Anna Jobin, présidente de la commission fédérale des médias et spécialiste des technologies digitales.

« La technologie n’est ni bonne, ni mauvaise, ni neutre », cette citation de l’historien des sciences Melvin Kranzberg est pour Anna Jobin un guide « pour se rendre compte de la vitesse des changements et de la cohabitation nécessaire entre nous et la technologie. » Cette réflexion donne le ton de la présentation de la chercheuse lors de la 24ème conférence annuelle de la Société suisse des sciences de la communication et des médias (SSCM) qui avait lieu les 18 et 19 avril 2024 à l’Université de Neuchâtel.

Chercheuse à l’Université de Fribourg, Anna Jobin y coordonne le nouveau master en digital society et est également la présidente de la commission fédérale des médias (COFEM). Ses recherches se concentrent sur les liens entre la société et les technologies digitales, en particulier sur le développement de l’intelligence artificielle. Un développement essentiel à comprendre, tant ces outils prennent une place importante aujourd’hui dans les débats entre journalistes, dans les rédactions et avec le grand public. Démystifier son fonctionnement et comprendre ses biais semble une arme essentielle pour tous les professionnels de l’information et de la communication.

L’IA n’est pas neutre

The Lancet – Prompt : African doctors administer vaccines to poor White children in the style of photojournalism.

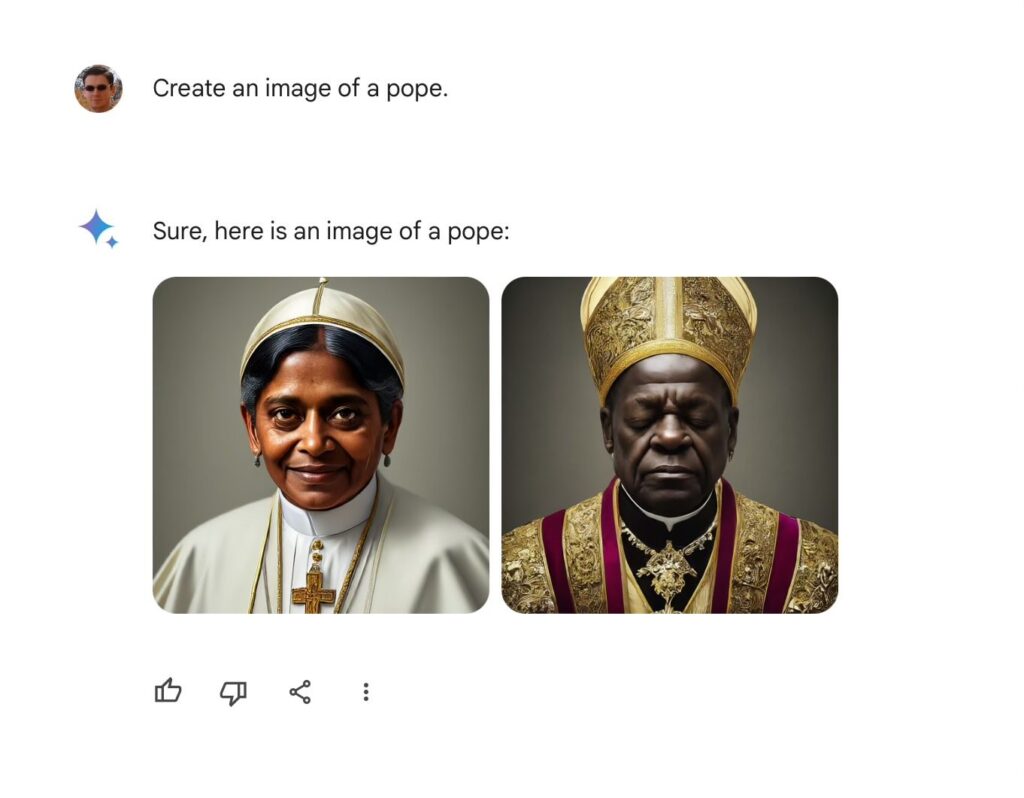

Il suffit de faire quelques requêtes à ChatGPT, Midjourney, Dall-e ou Gemini pour se rendre compte des biais que ces outils peuvent représenter. Il est, par exemple, plus probable d’obtenir une grande représentation de femmes lorsque l’on parle de tâches domestiques ou de foyer. Au contraire, d’avantage d’hommes blancs seront associés à un vocabulaire d’entreprise ou de business. Finalement, représenter un médecin noir soignant un enfant blanc relève de l’impossible.

Ces représentations stéréotypées ont poussé l’UNESCO à diriger une étude afin de quantifier ces biais. Pour causes, ces représentations ne sont pas sans risques. Selon, Audrey Azoulay, Directrice générale de l’UNESCO :

« Ces nouvelles applications d’intelligence artificielle générative ont le pouvoir de subtilement façonner les perceptions de millions de personnes, de telle sorte que même de légers préjugés sexistes dans le contenu qu’elles génèrent peuvent amplifier de manière significative les inégalités dans le monde réel. »

D’où viennent ces stéréotypes ?

Anna Jobin explique qu’il n’est pas surprenant que les nouvelles générations d’IA reproduisent les stéréotypes de notre société. En effet, les intelligences artificielles fonctionnent grâce au Machin et Deep Learning. Le Deep Learning, sous-catégorie du Machine Learning, fonctionne comme un réseau neuronal artificiel. Il s’agit donc d’algorithmes conçus pour fonctionner comme le cerveau humain, en apprenant à partir de grandes quantités de données. Dans ces bases de données, les IA « trouvent leur propre chemin » et lorsqu’une requête leur est soumise, elles présenteront le résultat le plus probable selon les représentations qui sont les plus répertoriées, les plus répandues dans les données d’apprentissage. C’est bien là que se trouve le problème. Les bases de données, même gigantesques, sont parfois la source d’un « sous-apprentissage ». Comprenez par là qu’il n’existe pas assez de données sur certains types de personne.

Ce constat a mobilisé l’UNESCO mais également « Numeum », le syndicat de l’industrie du Numérique. L’une des pistes de solution trouvées par ces organisations est de diversifier les équipes de développeurs et d’ingénieurs ou de faire appel à des sociologues. Ils espèrent que cela permettra de lutter contre les préjugés et d’inverser les tendances actuelles en termes de représentation dans le secteur de la Tech. A titre d’exemple, les femmes ne représentent que 22% des membres des équipes travaillant dans l’Intelligence artificielle au niveau mondial, selon les chiffres du forum économique mondial. L’instance onusienne appelle également les gouvernements à réguler ce secteur et mettre en place des « intelligences artificielles éthiques ». Ces recommandations ont par exemple motivé la création de l’IA act, une loi Européenne sur l’Intelligence Artificielle.

Quelles solutions ?

Pour Anna Jobin, il serait également possible de contrer activement ces biais en ajustant les modèles. Notamment en corrigeant ces biais dans les algorithmes ou dans le processus d’apprentissage des IA. On peut, à titre d’exemple, citer la tentative de Google de corriger les biais racistes de son IA génératrice d’image, Gemini.

Néanmoins, cette correction a créé des images incohérentes historiquement, notamment en produisant des inexactitudes en matière de genre ou de diversité raciale. Les vives réactions de nombreux internautes ont « occasionné la suspension de la fonctionnalité de génération d’images de personnes », avait déclaré, Jack Krawczyk, Directeur de produit chez Google en charge de Gémini.

Ces tentatives de corrections ne sont pas encore parfaites et les IA génératives en sont encore à leurs balbutiements. Les modèles, bases de données et algorithmes continueront d’être adaptés.

Toutefois, Anna Jobin attire notre attention sur le fait qu’il n’y aura jamais de modèle sans aucune erreur et sans aucun biais. Cela s’explique, selon elle, par le fait qu’il n’y a aucun modèle du monde réel qui représente telle quelle la complexité de notre réalité. Cette réflexion peut nous rappeler les rôles des journalistes. En effet, là où l’IA génère au plus probable, le journaliste doit lui choisir, angler, raconter sur la base d’une recherche de la vérité.

Des enjeux déjà pris en compte par la COFEM

Enfin, Anna Jobin nous précise qu’un travail sur les enjeux de l’essor de l’IA dans le secteur de l’information et de la communication a déjà été mené à la commission fédérale des médias. Se basant sur son expertise, elle a publié un document qui identifie cinq points clés ainsi que les risques et les opportunités qui les accompagnent.

Cet article a été réalisé à la suite de la Conférence annuelle de la Société suisse de communication et des médias qui avait lieu les 18 et 19 avril 2024 à l’Université de Neuchâtel.

Davantage de contenus sur l’intelligence artificielle sont à retrouver dans notre dossier thématique.

Cet article est publié sous licence Creative Commons (CC BY-ND 4.0). Il peut être republié à condition que l’emplacement original (fr.ejo.ch) et les auteurs soient clairement mentionnés, mais le contenu ne peut pas être modifié.

Tags: Anna Jobin, Artificial Intelligence, COFEM, Digital innovation, Digital Technologies, intelligence artificielle